✅ 사전학습 기반 언어모델의 한계

✔️ 사전학습 기반 언어모델의 한계점

•일반화 능력의 한계

•사람의 선호도 기반 답변 불가

•지식의 오래됨과 업데이트 문제

•계산 비용 및 환경 문제

•데이터 편향 및 윤리적 문제

•할루시네이션

✔️ 일반화 능력의 한계

라벨링된 데이터의 부족

•기존 사전학습 모델은 사전학습 → 미세조정의 두 단계를 거침

•이 과정에서 라벨링 데이터가 많이 필요하며, 부족할 경우 기대하는 성능을 얻을 수 없음

•라벨링된 데이터를 만드는 과정은 많은 노동이 필요

[이슈조명] AI 학습용 데이터 구축, AI 강국의 기반 다진다 < 이슈조명 < 기사본문 - 컴퓨터월드

미세조정 후 모델의 일반화 능력 상실

•사전학습된 모델을 미세조정할 경우, 일반화 능력이 상실됨

•사전학습 단계에서 가지고 있던 지식 대부분이 미세조정 과정에서 사라짐

• ex) 사전학습 BERT와 의료 진료 분석된 모델로 미세조정된 BERT에서

• 1. “서울에서 부산까지 KTX로 얼마나 걸리나요?”

• 2. “떡볶이는 매운맛과 달콤한맛 두 가지가 있어요.”

•사전학습 BERT는 위의 두 문장을 어느정도 이해 함

•반면, 미세조정된 BERT는 위의 두 문장을 의료 용어로 혼동함

Catastrophic Forgetting in Large Language Models | by Abdulkader Helwan | Medium

✔️ 사람의 선호도 기반 답변 불가

•사람의 선호도에 대한 정보를 가지고 있지 않기 때문에, 사용자가 원하는 답변을 주기 어려움

•사람의 선호는 매 상황마다 다를 수 있음

•또한, 모델이 생성한 결과의 좋고 나쁨은 사전학습 모델링 기법으로 극복 불가

• ex) “커피와 차 중 어느 것을 살까요?” 라는 사람의 질문에서

•기존의 미세조정된 언어모델은 “간단하게 설명해줘”라는 두 번째 요청을 단독으로 처리할 수 없음

✔️ 지식의 오래됨과 업데이트 문제

•기존 사전학습 모델은 사전학습 당시 사용됐던 데이터의 지식을 바탕으로 학습이 됨. 따라서, 변화하는 지식을 대처하기 위해서는 새로 사전학습을 진행해야 함

• ex)

새로운 지식 처리 불가: 2018년까지 데이터로 학습된 사전학습 모델은 2019년에 발병한 COVID-19에 대한 지식이 없음

변화하는 지식 처리 불가: 2018년까지 학습된 사전학습 모델은 Brexit가 EU 탈퇴 논의를 거치는 것으로 학습하였으나, 2020년에 EU 탈퇴가 된 지금 시점에서는 잘못된 지식으로 처리할 수 있음

✔️ 계산비용과 환경문제

•사전학습 모델 학습 및 사용은 기술적 혁신을 가져오는 반면, 모델을 훈련하고 유지하는 데 필요한 방대한 자원으로 인해 상당한 탄소를 배출하여 심각한 환경 문제를 야기

•가령, LLaMA2 모델 학습은 539톤의 CO2를 배출 (163 가구가 1년 사용할 수 있는 전력량)

The Carbon Impact of Large Language Models: AI's Growing Environmental Cost

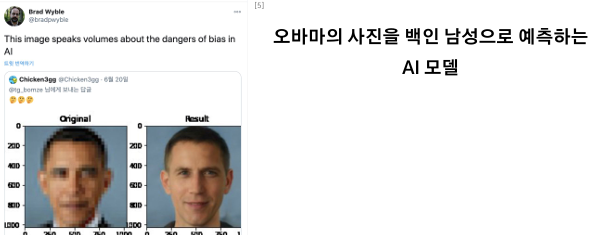

✔️ 데이터 편향 및 윤리적 문제

데이터 편향 문제: 사전학습 모델은 특정 코퍼스로 학습되어 해당 코퍼스에서 자주 등장하는 특성으로 편향됨. 이는 성별, 인종, 종교 등의 편향을 발생

• Gender Bias: 성별에 따라 단어나 문장을 다르게 해석하는 편향

• ex) 의사를 남성으로 가정, 간호사를 여성으로 가정

• Racial Bias: 특정 인종이나 민족에 대해 부정적인 연관성 등을 가지는 편향

• ex) 흑인이 입력되었을 때, 범죄와 관련된 단어 확률이 증가

• Age Bias: 특정 언어에 대해 불공정한 처리 등을 하는 편향

• Socioeconomic Bias: 경제적 지위에 따라 선입견을 가지는 등의 편향

• ex) 저소득층은 범죄율이 높다는 등의 경제적 스테레오타입을 반영

•…

모든 편향 (bias)은 나쁜 것은 아니지만, Social bias 등과 같은 사회적 이슈를 발생할 수 있는 편향은 모델이 독성 정보를 뱉을 수 있음

✔️ 할루시네이션 (Hallucination)

• Hallucination: 모델이 사실과 무관하거나 존재하지 않는 정보를 생성하거나, 확인할 수 없는 정보를 생성하는 현상

• Intrinsic Hallucination → Source에 있는 정보들을 사용해서 합성된 잘못된 정보가 결과로 나온 경우

• Extrinsic Hallucination → Source에서 찾을 수 없는 정보가 등장한 경우

Hallucination은 대부분 생성모델에서 발생

✅ 미래 지향적 언어모델 개발 방향

✔️ 미래 지향적 언어모델 개발 방향

• 지속가능한 모델 개발

• 사람의 선호도 기반 모델 개발

계산 비용 감소 연구 추진

• 데이터 편향 완화 기술 개발

• 모델 해석 가능성 및 투명성 강화

✔️ 지속가능한 모델 개발 - Continual Learning

Continual Learning

•데이터 수집, 정제, 모델 학습, 테스트까지 자동화하여 지속적인 LM을 업데이트하는 과정

•새로운 정보를 학습하면서, 이전에 학습한 지식을 잊지 않도록 학습하는 것이 주요 목표

Lecture 6: Continual Learning - The Full Stack

✔️ 지속가능한 모델 개발 - 검색기반 생성모델

RAG (Retrieval-Augmented Generation)

•생성모델 하나를 사용하는 것이 아닌, 검색모델과 생성모델을 같이 사용하여 작동

•검색모델에서 사용되는 데이터베이스로 새로운 정보를 생성모델에게 전달

•검색모델과 생성모델을 따로 학습하지 않고, 데이터베이스 업데이트 만으로 정보 업데이트 가능

✔️ 지속가능한 모델 개발

Self-Improvement

•인간의 개입 없이 모델 추론 결과를 통해 잘 모르는 지식을 스스로 개선하게 하는 학습 방법

•라벨링되지 않은 데이터를 활용하여 잘 모르는 지식들을 일부의 데이터만 추출해 학습하는 것이 트렌드

✔️ 사람의 선호도 기반 모델 개발

In-context Learning

• Task description 혹은 프롬프트를 통합하여 추론 중에 파라미터를 업데이트 하지 않고 답변을 생성하게 하는 학습 방식

•모델은 주어진 예시를 통해 학습 없이 Few-shot inference를 할 수 있음

• Task description의 활용으로 사람의 선호도를 반영할 수 있음

In-Context Learning, In Context

Human Preference Tuning

•사람의 선호도 기반 데이터를 통해 LM을 사람의 선호도가 최상이 되도록 미세조정 하는 방법

•대표적으로 RLHF, DPO 등이 있음

✔️ 계산 비용 감소 연구 추진

학습에 적절한 Hyper-parameter 찾기

• BERT-base는 16 TPU chips로 4일동안 학습되었음

•동일한 조건에서 BERT-base 등의 사전학습을 1개의 GPU로 하루동안 진행하는 연구 존재

✔️ 편향 완화 (debias) 기술 개발

•언어모델 혹은 데이터 내에 편향을 완화하는 연구 개발

•데이터 전처리, 언어모델 개선, 벤치마크 개발 등의 다양한 연구 존재

• LLMs 등장 이후로 더욱 화제가 됨 (Human Preference Tuning이 이러한 생성을 억제한다?)

'04_NLP(Natural Language Processing)자연어처리 > LLM' 카테고리의 다른 글

| Large Language Model의 근간 이론들 (1) | 2025.02.06 |

|---|---|

| Large Language Model 이란? (1) | 2025.02.06 |

| 문맥기반 언어지식 표현체계 이론 Ⅱ (0) | 2025.02.05 |

| 의미기반 언어 지식 표현 체계 이론 (0) | 2025.02.05 |

| 언어모델 평가 방법 (1) | 2025.02.04 |